区块链中的数据可用性是什么?解密分布式信任的核心机制

在传统金融体系中,我们习惯于将信任托付给银行这样的中心化机构。当我们进行转账时,银行账本上数字的变化就是交易完成的证明——尽管这些账本数据被严密保管在银行的数据库里,普通用户永远无法亲眼所见。这种信任模式运行了数百年,直到区块链技术提出一个革命性质疑:如果连数据都看不见,我们如何确信它没有被篡改?

区块链用数学和密码学重构了信任机制。当比特币在2009年诞生时,它向世界证明:通过分布式账本和共识算法,陌生人之间可以建立无需中介的信任。但这里浮现出一个更本质的问题——在数字世界里,数据既看不见也摸不着,我们如何确保每个节点获取的数据都是完整且真实的?如果某些关键数据被故意隐藏,整个系统的可信度将面临怎样的挑战?

这个问题直指区块链的核心矛盾:去中心化系统必须保证所有参与者都能独立验证数据,但同时又不能让数据存储成为普通用户的不可承受之重。就像法庭审判需要所有证据公开质证,区块链网络也需要确保每个验证者都能获取完整的"证据链"。当Vitalik Buterin谈到"数据可用性"时,他真正讨论的正是这种分布式系统中独特的信任建立方式。

数据可用性的本质

区块链中的数据可用性可以类比快递单号追踪系统。就像我们通过单号能随时查询包裹位置,区块链网络中的每个节点都必须能够获取验证交易所需的完整数据。但关键区别在于:快递公司只需向收寄双方提供查询权限,而区块链要求所有验证数据必须向全网公开可查。

这种"必须公开"的特性源于区块链的验证机制本质。以比特币交易为例:当矿工打包交易时,必须将包含所有输入输出详情的交易数据完整广播。其他节点会像验货员一样,需要拆开整个"数据包裹"核对:

1. 验证UTXO未被重复花费

2. 检查数字签名有效性

3. 确认交易金额合规性

如果只提供交易哈希(类似快递单号)而隐藏具体数据,就像只告知"包裹已发出"却不提供物流详情,整个验证体系将瞬间崩塌。这正是中本聪在设计比特币时要求每个区块必须包含完整交易数据的根本原因——可验证性必须建立在数据强制公开的基础上。

去中心化系统的生命线

当医生藏起病历时:验证缺失的致命风险

想象一位拒绝出示病历的医生,患者将陷入对诊断结果的永恒怀疑。这正是区块链网络面临的数据可用性危机——当矿工选择性地隐藏交易数据时,整个系统将丧失最基础的验证能力。与中心化系统不同,区块链的信任机制要求每个节点都能独立复现验证过程,任何数据缺失都会像被撕毁的账本页,使系统暴露在系统性风险之中。

矿工作恶的两种数据操纵模式

恶意矿工通常采用两种攻击方式:其一是"区块数据扣留",仅发布区块头而隐藏交易明细,使其他节点无法验证交易合法性;其二是"状态数据篡改",通过精心构造的虚假默克尔证明,制造已包含特定交易的假象。这两种手段都利用了验证环节的数据盲区,如同魔术师通过控制观众视线完成的障眼法。

The DAO事件的警示录

2016年以太坊The DAO攻击事件深刻揭示了验证缺失的灾难性后果。由于攻击者利用智能合约漏洞实施的交易未能被及时验证,最终导致价值6000万美元的ETH被转移。这一事件不仅迫使以太坊进行硬分叉,更暴露出当关键数据无法被全节点及时核验时,整个系统将面临不可逆的信任崩塌。数据可用性在此刻显现出作为区块链生命线的本质价值——它既是防御作恶的最后屏障,也是维持系统共识的基础氧气。

不同链架构的验证难题

比特币UTXO模型的验证特征

比特币采用的UTXO(未花费交易输出)模型具有独特的验证特性。在该模型中,每笔交易都明确引用先前的交易输出作为输入,形成可追溯的链式结构。节点验证时只需检查UTXO集合中是否存在对应的输出,无需关注账户历史。这种设计使验证过程具有天然的原子性,每个交易都可独立验证,极大简化了数据可用性要求。但全节点仍需维护完整的UTXO集合,新节点同步时需下载整个历史交易数据来重建当前状态。

以太坊账户模型的状态验证挑战

与比特币不同,以太坊采用账户余额模型,引入了更复杂的全局状态验证需求。智能合约的执行会改变世界状态,每个新区块都包含状态根的哈希值。验证者必须确保:1)所有状态转换都符合规则;2)最新状态根正确反映了所有历史交易。这要求全节点不仅要存储交易数据,还需维护完整的状态树。随着状态数据膨胀,验证难度呈指数级增长,成为制约以太坊可扩展性的关键瓶颈。

状态通道验证的"图书馆查书"比喻

理解不同链下方案的验证差异,可以借助图书馆的比喻:比特币UTXO验证如同查证某本书的借阅记录——只需确认当前是否在馆;以太坊状态验证则像核对整个图书馆的目录系统——需要确保每本书的存放位置与目录完全一致;而状态通道的验证则类似两位读者私下交换书籍——只有在归还图书馆时才需要公开登记,期间的所有临时流转都不需要全局验证。这种差异直接影响了各架构对数据可用性的需求层级。

数据失踪的灾难现场

复现2016年比特币区块验证危机

2016年比特币网络曾遭遇区块验证危机,部分矿工试图通过隐藏交易数据来操纵区块验证过程。当节点无法获取完整的区块数据时,整个网络的验证机制就会陷入瘫痪。这种数据可用性危机直接威胁到区块链最核心的信任基础——可验证性。

演示零知识证明中的数据陷阱

零知识证明技术虽然能保护隐私,但也可能成为数据藏匿的"完美掩护"。某些恶意节点可能利用零知识证明的特性,在提供验证证明的同时,故意不公开关键交易数据。这种"知道结果但看不到过程"的困境,使得网络面临潜在的双花攻击风险。

通过"消失的借条"案例解释验证缺失风险

想象一个去中心化借贷平台:如果借款人能隐藏关键的还款凭证数据,即使智能合约显示债务已清偿,实际资金可能早已被转移。这种"消失的借条"现象正是数据可用性缺失的典型风险——当验证所需的关键数据被隐藏,再完善的智能合约也会失效。

突破性解决方案全景

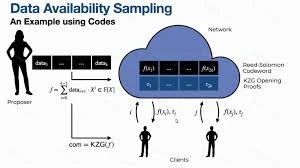

数据抽样:像质检员抽检产品般验证

数据可用性抽样(DAS)技术正在重塑区块链验证范式。该技术借鉴工业质检中的抽样原理,允许节点仅需随机检查区块数据的部分片段即可验证整体数据可用性。通过概率学保证,当抽样次数达到阈值时,数据完整性的验证准确率可提升至99.99%以上。这种创新将全节点验证的数据负载降低90%,同时保持同等安全级别。

擦除编码:用数学公式重建丢失数据

基于信息论的擦除编码技术为数据可用性提供了数学保障。该技术将原始数据扩展为带有冗余校验的编码数据,即使50%的数据片段丢失,仍可通过Reed-Solomon等算法精确重建原始数据。在以太坊分片方案中,擦除编码使网络能在节点仅存储1/N数据的情况下,确保全局数据完整性,实现了存储效率与安全性的完美平衡。

Celestia的模块化革命:区块链界的"专业质检公司"

Celestia首创的模块化架构将数据可用性层从执行层中解耦,如同专业质检机构独立于生产体系。其采用二维RS编码方案,配合概率抽样检测,构建了可验证的分布式数据库。测试数据显示,该架构使轻节点在仅下载0.1%区块数据的情况下,能实现与全节点等效的数据验证能力,为模块化区块链生态奠定了技术基础。

Layer2的验证新战场

乐观汇总的信任悖论:1周挑战期的生死时速

乐观汇总(Optimistic Rollups)采用"先信任后验证"的独特机制,其核心在于7天挑战期设计。这就像银行给客户设置的交易异议期——在7天内任何验证者都可以提交欺诈证明。但这也带来一个致命悖论:如果在此期间原始数据被故意隐藏,整个网络将失去纠错能力。2023年Arbitrum网络曾出现因数据延迟导致200万美元资产暂时冻结的事件,正是这种机制风险的现实印证。

ZK-Rollups的数学保险箱:证明比数据本身更重要

ZK-Rollups通过零知识证明技术实现了验证范式的革命性突破。其精妙之处在于:验证者只需要检查密码学证明的正确性,无需知晓具体交易细节。这就像用数学公式给数据上了双重保险——即使部分数据丢失,只要有效性证明存在,系统仍能保持安全。StarkNet的实际测试显示,其ZK证明可使验证数据量压缩至原始交易的0.3%,但验证成本仍是制约大规模应用的瓶颈。

DAC委员会的信任背书机制解析

数据可用性委员会(DAC)作为Layer2的"安全卫士",采用多签门限机制来平衡效率与安全。以Polygon Avail为例,由21个知名机构组成的DAC需达到2/3多数签名才会释放数据。这种设计既避免了单一中心化风险,又通过经济质押惩罚恶意行为。但2024年3月某DAC成员串通隐瞒数据的事件表明,这种半中心化方案仍需完善声誉机制和随机轮换制度。

DeFi系统的信任传导链

区块链金融体系中的信任危机往往呈现多米诺骨牌效应。闪电网络支付验证困境揭示了二层网络的致命弱点——当通道参与者无法获取完整的交易数据时,整个支付通道可能陷入"盲人摸象"的验证僵局。这种数据黑洞会导致资金被恶意锁定,如同没有监控录像的自动取款机,用户无法证明资金流向的真实性。

预言机数据可用性危机则是智能合约世界的阿喀琉斯之踵。2020年3月"黑色星期四"事件中,Chainlink预言机因网络拥堵延迟更新价格数据,直接引发MakerDAO系统数百万美元的不良债务。这暴露出DeFi生态的脆弱性:即便底层区块链数据完全可用,外部数据源的断裂同样会摧毁整个信任体系。

最具警示意义的是2021年Compound的清算事件。当预言机报价出现异常波动时,由于缺乏实时数据验证机制,系统自动触发了错误清算。这个价值9000万美元的事故链条表明:在多层嵌套的DeFi协议中,任何一个环节的数据验证缺失,都会通过智能合约的自动执行产生指数级放大效应。就像精密齿轮组中混入一粒沙,最终可能导致整个机械系统的崩溃。

跨链时代的信任桥梁

在区块链的跨链交互中,数据可用性面临着独特的验证挑战。跨链桥作为连接不同区块链的枢纽,其核心在于建立可信的验证机制。目前主流方案采用"轻客户端+中继器"架构,通过持续同步源链区块头信息,使目标链能够独立验证跨链交易的真实性。这种机制如同在两个独立王国间建立互认的护照查验系统,关键在于确保验证数据的完整可查。

Cosmos的IBC协议展现了精妙的区块头验证设计。其采用默克尔树结构压缩验证数据,配合轻客户端仅需同步关键区块头,就能实现对历史交易的完备验证。这种方案如同在两个图书馆间建立索引互查系统,既避免了全量数据复制,又确保了验证的严谨性。

Polkadot则创新性地构建了共享验证人网络。通过中继链统一协调,各平行链的验证人共同参与全网状态验证,形成天然的跨链数据可用性保障。这种设计类似于跨国企业集团的联合审计机制,通过利益绑定实现验证责任的分布式承担。

未来验证技术演进

区块链数据可用性验证技术正迎来三大突破性方向:

- 预言数据可用性证明的数学革命 基于多项式承诺和零知识证明的新型验证算法正在颠覆传统模式。Verkle树等数据结构可将证明尺寸压缩至传统Merkle证明的1/10,而FRI协议则实现了亚线性复杂度的数据完整性验证。这些突破使得节点仅需验证KB级证明就能确认TB级数据的可用性。

- 分布式存储与区块链的融合 IPFS、Arweave等存储协议与区块链验证层形成互补架构。通过内容寻址和激励层设计,重要历史数据可永久保存,而区块链只需存储最新状态和验证元数据。这种分层验证体系将TPS提升2-3个数量级的同时,仍保持拜占庭容错能力。

- 量子验证技术的可能性 IBM量子计算机已实现127量子位运算,后量子密码学中的格基证明和哈希签名算法开始进入测试阶段。未来量子网络可能实现跨链状态的瞬时验证,通过量子纠缠特性构建无法被阻断的验证通道,彻底解决数据扣留攻击问题。

这些技术演进将重构区块链信任基础设施,使验证效率与安全性突破现有理论极限。

Web3起点网

Web3起点网